De voorzitter van de Europese Commissie, Ursula von der Leyen, verklaarde recentelijk dat “misinformatie en desinformatie” grotere bedreigingen vormen voor het mondiale bedrijfsleven dan oorlog en klimaatverandering.

Veel mensen maken zich zorgen over de manipulatieve technieken van de grote social mediaplatforms, die doelgericht aandacht trekken om geld te verdienen. Zo wakkeren online media vaak met triggerende berichten emotie en sensatie aan: online-manipulatie.

Podcast

Op die manier wordt mis- en desinformatie makkelijk verspreid. De nieuwe digitale omgevingen met gerichte online-manipulatie vormen geheel nieuwe uitdagingen voor de cognitie en aandacht van mensen. Hoewel het geloof in onwaarheden en samenzweringstheorieën niet nieuw is, hebben de snelheid en het bereik van het internet desinformatie een grotere kracht gegeven.

Sommige individuen verspreiden eerst desinformatie met expliciet antidemocratische bedoelingen. Het motto van Trump-vriend Steve Bannon was dan ook “Flood the zone with shit”. Vervolgens uitvergroten Social media extreme meningen en polarisatie. Algoritmen ondersteuen daarbij misleidende beweringen omdat digitale platforms met deze uitvergroting en vermenigvuldiging van berichten meer geld verdienen.

Sociale media versterken altijd de luidste stemmen, ongeacht hun kennis of expertise. Er wordt dus een verkeerde indruk gewekt dat de meerderheid van burgers boos en gepolariseerd is.

“Disinfonomics”: Desinformatie is Big Business!

Digitale media zijn beter afgestemd op verontwaardiging en desinformatie dan op conversatie en kennis. Negatieve en opruiende inhoud maximaliseert de betrokkenheid, omdat mensen van nature hun aandacht op een mogelijk gevaar richten (negativiteitsbias). Deze negatieve bias-spiraal is een serieuze bedreiging voor de democratie, omdat wantrouwen in democratische instellingen wordt aangewakkerd en geweld uitgelokt. Bewust negatieve inhoud bewerkt polarisering.

De onderzoeksgroep rondom socialpsycholoog Jay van Bavel heeft de “4 zwarte wetten van online-betrokkenheid” geformuleerd:

- Negativiteitsbias: meer aaandacht voor gevaren

- Gedeelte extreme meningen houden een virtuele groep bij elkaar

- Gedeelte vermeende vijanden zorgen voor verbondenheid in de groep en haat tegen mensen buiten de groep

- Morele verontwaardiging drijft de emotie.

Trolling, verontwaardiging, anonimiteit

Dankzij de dynamiek van sociale media kan iedereen deelnemen aan groeps-verontwaardiging met weinig of geen persoonlijke kosten of risico. Iedereen kan makkelijk verschuilen achter anonimiteit. Deze anomieme en sociale verontwaarding voelt fijn voor mensen. De woede bindt de ingroep en keer zich tegen de outgroup. Morele verontwaardiging is gratis en geeft bovendien status.

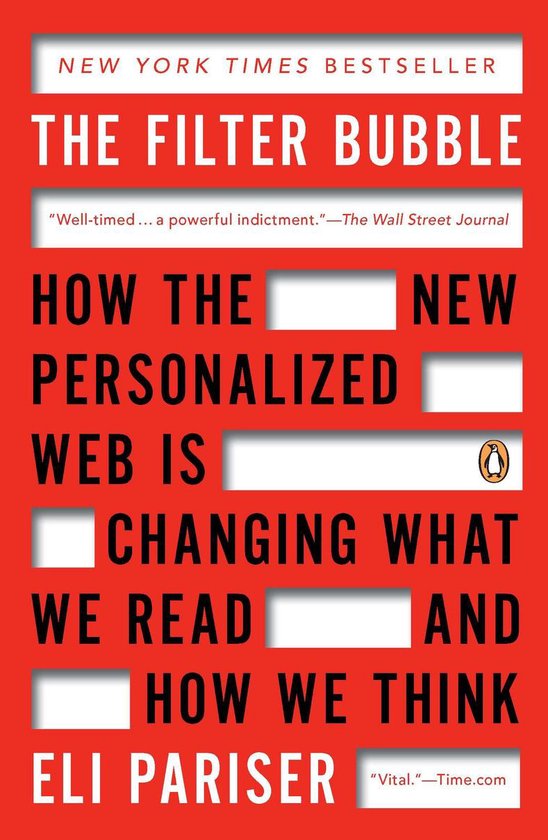

“Echokamers” en filterbubbels bevestigen de eigen ideeen en de “confirmation bias” van mensen. Versterkende processen binnen deze online-groepen leiden tot selectieve blootstelling, selectieve aandacht en selectief vasthouden van informatie – een proces dat uiteindelijk kan leiden tot groepspolarisatie.

Ook het proces van radicalisering wordt binnen online gemeenschappen aangewakkerd. Zo dragen sociale media-platforms bij tot een toenemende betrokkenheid bij (samenzwerings)-radicalisering.

Iedereen is kwetsbaar voor misleiding

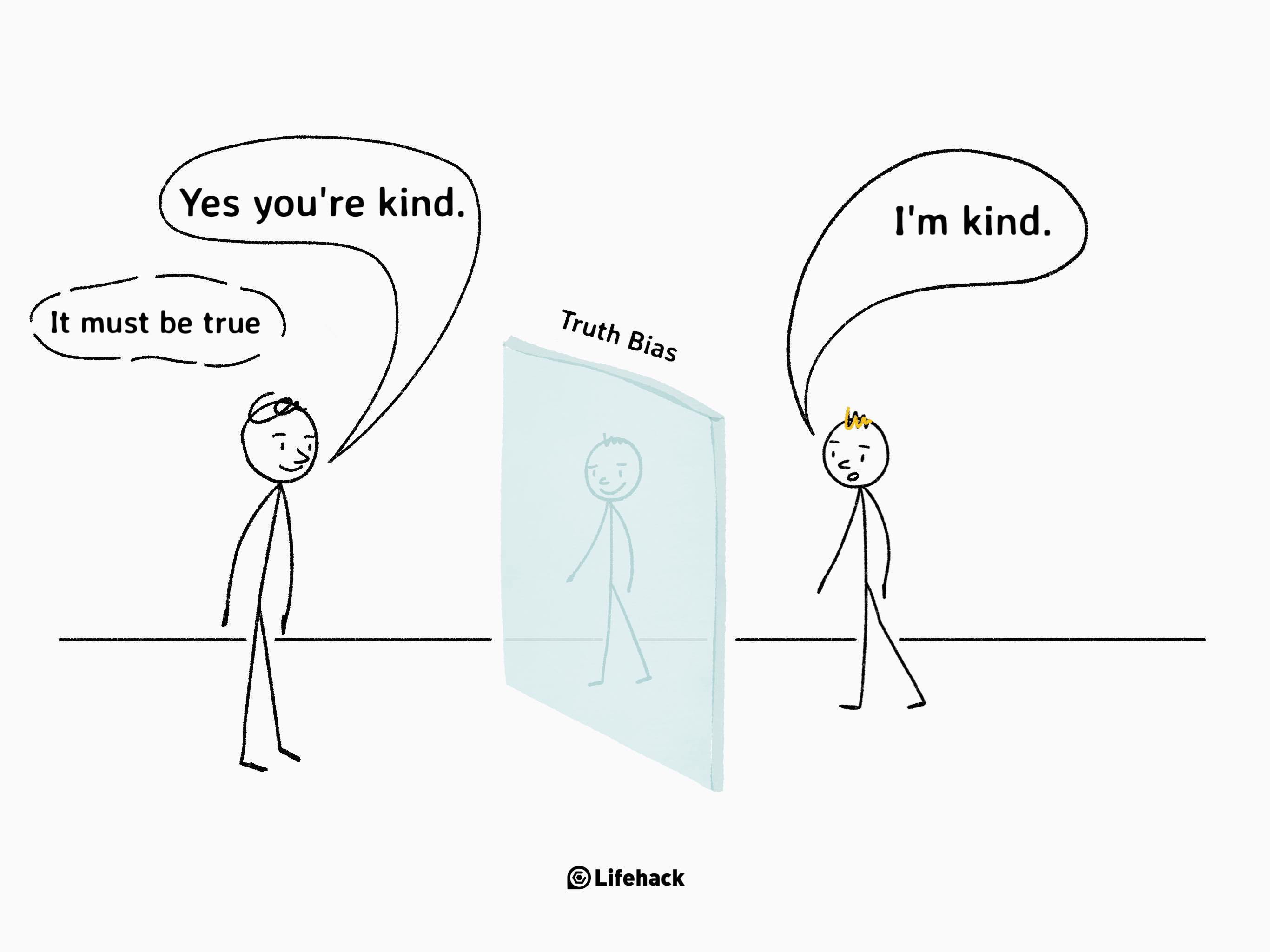

Mensen nemen over het algemeen aan, dat de ander de waarheid vertelt. Waarheidsbias is de neiging van mensen om, tot op zekere hoogte, de communicatie van een andere persoon te geloven, ongeacht of die persoon daadwerkelijk liegt of onwaarachtig is. Het ligt in de aard van de mens om te geloven dat communicatie eerlijk is. En dat maakt de mens zeer kwetsbaar voor misleiding .

Een tweede tendens die mensen kwetsbaar maakt is het zogenaamde “illusoire waarheidseffect “illusionary truth” (zie Sander van der Linden). Omdat onze hersenen liefst snel en moeiteloos willen waarnemen en oordelen, wordt herhaalde informatie eerder als “waar” beoordeeld dan minder herhaalde informatie. Zo worden de uitvergrote en via algoritmes steeds weer herhaalde onwaarheden (rabbit hole-effect) op social media makkelijk als waar herkend, tenzij men tijd en moeite eraan besteed het waarheidsgehalte kritisch te toetsen (fact-checking).

Sociale mediaplatforms hebben een financiële prikkel om inhoud te versterken die sensationeel, polariserend en nep is.

José van Dijck Universiteitshoogleraar media en digitale samenlevding, Universiteit Utrecht

Filter bubble: Rabbit hole effect (“fabeltjesfuik”)

“Platforms als Facebook en YouTube willen onze aandacht zo lang mogelijk vasthouden om advertenties te verkopen. En daarom bieden ze dingen aan waarvan het systeem weet dat je dat interessant vindt.

Je denkt dan ook dat je zelf kiest welk filmpje gaat kijken, maar eigenlijk zit je in een nauwer tunneltje dan ooit: de fuik. En hoe langer mensen in die fuik zitten, hoe meer ze openstaan voor radicale ideeën die ze zelf nog niet hadden.” (Zondag met Lubach)

Digitale media versterken op die manier de zogenaamde confirmation bias door het ontstaan van een filterbubbel. Gebruikers krijgen voornamelijk informatie te zien die aansluit bij hun politieke of maatschappelijke gezindheid op basis van eerder klikgedrag en zoekgeschiedenis.

Wat kunnen we tegen online-manipulatie doen?

In eerste instantie moeten dus Social Media platforms zelf worden verplicht om misinformatie tegen te gaan. Hier ligt een taak voor de politiek. Onderzoek laat namelijk zien, dat de structuur van online delen, die ingebouwd is in sociale platforms, belangrijker is dan individuele tekortkomingen in kritisch redeneren en partijigheid. De ingebouwde structuur van social media is dus het hoofdprobleem.

Nieuwe wetgeving

Er is nu recentelijk een belangrijke politieke stap gezet in het gevecht tegen digitale misinformatie op social media: de nieuwe Europese Digital Services Act (Verordening digitale diensten ) is dan ook een belangrijke stap. Deze verordening zal nu ook zoekmachines en grote online platforms dwingen om strenger op te treden tegen haat en opruiing en andere illegale inhoud op het net.

“De DSA doorbreekt de regels ten aanzien van de aansprakelijkheid van de social media platforms voor het type content en voor de economische transacties op hun platform. “

Catalina Goanta Universitair hoofddocent privaatrecht en technologie, Universiteit Utrecht

In een brief aan Elon Musk waarschuwt de digitale chef en commissaris van de Europese Unie, Thierry Breton, dat terroristische propaganda en gemanipuleerde beelden zich op zijn platform verspreidden. Breton onderstreept, dat de EU haar nieuwe wet die digitale bedrijven regelt, de Digital Services Act, streng zou handhaven.

Zo ver de politieke maatregelen. Maar ook op individueel niveau zijn er mogelijkheden om mensen te stimuleren, beter met desinformatie om te gaan.

Wat kunnen we op individueel niveau doen?

Om individueel beter met online-manipulatie om te kunnen gaan is een actieve houding en meer mediawijsheid nodig. Wetenschappers hebben nieuwe methodes ontworpen, hoe mensen weerstand tegen desinformatie en online-manipulatie kunnen opbouwen. Twee ervan zal ik hier laten zien:

- Prebunking van online-manipulatie

- Kritisch ignoreren van aandachtsmanipulatie

Prebunking: weerbaarheid tegen desinformatie en online-manipulatie

Is er misschien een preventieve methode die mensen beschermt tegen manipulatie? Bestaat er naast fysieke inenting ook een soort van “cognitieve inenting”, inenting tegen emotioneel manipulatieve marketing en politieke berichtgeving (nepnews)? Is het mogelijk om met een soort van cognitieve inenting weerstand tegen desinformatie te kweken?

Er bestaat inderdaad een wetenschappelijke theorie, de “inoculation theory” (NL Resistentietheorie). Dit is een sociaal-psychologische communicatietheorie die verklaart hoe iemand kan worden beschermd tegen ongewenste manipulatie of beïnvloeding. De bescherming gebeurt hier dan niet door lichamelijke inenting, maar doordat mensen de manipulatieve technieken leren te doorzien die door sociale media veel worden ingezet. De bescherming zou dan op ongeveer dezelfde manier gebeuren als een lichaam kan worden beschermd tegen ziekte. Bij inenting leert het lichaam een virus in een minimale dosering kennen en kan zich later beter verweren, bij de psychologische inenting leert men de manipulatieve technieken kennen, zodat men later minder makkelijk prooi wordt. Deze cognitieve preventie (“prebunking”) en waarschuwing verbetert de weerbaarheid van het publiek tegen desinformatie en nepnieuws. Zo kan bijvoorbeeld wetenschapsontkenning, riskant gezondheidsgedrag, emotioneel manipulatieve marketing en politieke berichtgeving aangepakt worden.

Desinformatie

Desinformatie is ernstiger geworden met de komst van het internet. De mogelijkheid van onmiddellijke en anonieme communicatie maakt het internet een ideaal voertuig voor misleiding. Veel wetenschappers werken daarom aan preventie tegen manipulatieve online-beïnvloeding.

Sociaalpsycholoog Sander van der Linden is beroemd voor zijn onderzoek over sociale beïnvloeding en onderzoek gebaseerd op de inoculatietheorie. Het vooraf waarschuwen van mensen en hen blootstellen aan een sterk afgezwakte dosis valse informatie/fake news/Nepnieuws kan als het ware psychologische weerstand tegen valse of misleidende informatie kan opwekken.

Sander van der Linden heeft een aantal instrumenten en technieken ontwikkeld om de inoculatietheorie in de praktijk toe te passen en desinformatie tegen te gaan. De nadruk op preventie (“inoculatie” “cognitieve inenting”) is belangrijk, omdat het bijna onmogelijk blijkt mensen te overtuigen die al overtuigd zijn geraakt van misinformatie. Deze personen staan zelden open voor nieuwe informatie, correctie “fact checking” of “debunking” . Wie overtuigd is geraakt van bijvoorbeeld komplottheorieen maakt vaak deel uit van sociale netwerken waar misinformatie steeds verder wordt uitgewerkt en uitgediept.

Online game Bad News

Onderzoeker Van der Linden heeft een aantal educatieve middelen en materialen ontwikkeld. Deze materialen omvatten online interactieve hulpmiddelen die zijnontworpen voor aantrekkelijk en gemakkelijk gebruik, zoals preventieve video´s voor YouTube. Daarnaast heeft Van der Linden samengewerkt met een aantal organisaties en instellingen om campagnes en interventies te ontwikkelen en te implementeren die mensen moeten helpen zich te beschermen tegen de invloed van verkeerde informatie. Samen met Jon Roozenbeek ontwikkelde hij “Bad News“, een interactieve educatieve ervaring: The Fake News Game.

Dit spel laat spelers in de huid kruipen van een producent van nepnieuws. Spelers leren de strategieën van desinformatie te doorzien door deze zelf te gebruiken. De desinformatie-technieken, die de spelers leren kennen, omvatten: Sturen op impersonatie (fake personen of links), emotie, polarisatie, trolling, complottheorieën verzinnen, tegenstanders in diskrediet brengen. Allemaal online manipulatieve technieken. Als je het zelf in het spel leert om manipulatieve middelen te gebruiken zoals angstzaaierij, zondebokvorming, valse vergelijkingen, overdrijving en het weglaten van context, dan zie je hoe makkelijk dit ook is voor een ander.

Het spel Bad News kan in vele talen worden gespeeld o. a. ook in Russisch, ook al zegt Van der Linden, dat de culturele context nog niet op de Russische desinformatie is aangepast. Daaraan wordt nog gewerkt. Politike desinformatie en proganda is een belangrijk domein voor preventie. Op YouTube gaat Van der Linden overigens ook uitvoerig in op de desinformatie rondom Oekraïne en geeft een link voor de Oekraïnse versie van Bad News getbadnewsukraine.com

Filmpjes over online-manipulatie

Van der Linden en Roozenbeek werken samen met Google om korte, leuke animatiefilmpjes op YouTube te plaatsen die gebruikers leren om de boven genoemde veelvoorkomende desinformatie-technieken te herkennen en te analyseren, zoals het tot zondebok maken van anderen. De video’s bevatten humoristische voorbeelden van deze strategieën aan de hand van personages uit populaire televisieprogramma’s en films als Family Guy en Star Wars. (De video’s kunnen online worden bekeken).

De resultaten van de prebunking/psychologische inenting zijn bemoedigend (Roozenbeek et al., 2022).

In maart verschijnt het nieuwe boek van Sander van der Linden “Immuun voor nepnieuws” (… eerst was een ietwat ongelukkige titel “Het waarheidsvaccin” gepland). In het Engels is het boek al verschenen met de betere titel “Foolproof”. Sander van der Linden laat hierin op een overtuigende manier zien hoe ons brein werkt en waarom het zo moeilijk is voor mensen om feiten van misinformatie te onderscheiden.

Kritik op de “inoculatie”-theorie

Van verschillende kanten wordt kritisch gereageerd op de inoculatietheorie. Critici wijzen erop, dat mensen juist niet makkelijk beinvloedbaar zijn. Mensen beschikken over goede cognitieve mechanismen om gecommuniceerde informatie te evalueren. Hugo Mercier heeft een heel boek geschreven over het feit, dat mensen helemaal niet makkelijk beinvloedbaar zijn. Dat er toch veel misvatting over medische vaccinatie en klimaatvernadering zijn, komt niet door “inocculatie” door meesterlijke overtuigers, maar doordat veel populaire overtuigingen in intuitie zijn verankerd. Intuitie is niet de weg van de moderne wetenschap of moderne samenleving.

Ook wordt vooral vanuit een bepaalde identiteit (politiek of anti-establishment) informatie gekozen….of er wordt veel geld met het verspreiden van misinformatie verdiend. Het blijft in ieder geval al daarom een feit, dat wij het verspreiden van misinformatie moeten straffen, of op z’n minst moeten ontmoedigen. Dat geldt ook als wij het liever niet over een of andere vaccinatie tegen desinformatie willen hebben.

Leren, om online-manipulatie bewust te filteren

In het artikel Critical Ignoring as a Core Competence for Digital Citizens stellen Kozyreva et al., dat het nodig is om te leren online-informatie van lage kwaliteit en misleidende informatie te weerstaan. Natuurlijk is het vooral wenselijk dat platforms zelf een monitoring-policy invoeren en op deze manier al een bepaalde voorselectie maken en de ergste desinformatie weren. Maar het blijft nodig, om ook op individueel niveau te filteren.

Online-platforms en auteurs proberen doelgericht en ondersteund door algoritmes nieuwsgierigheid, verontwaardiging of woede op te roepen.

Dit lukt vaak beter met foutieve informatie dan met juiste informatie. Om online-manipulatie te weerstaan moeten mensen nieuwe mentale gewoonten aannemen. Gewoonten, die hen helpen om zich niet te laten verleiden door aandachttrekkende en potentieel schadelijke inhoud. Kozyreva et al. stellen dat digitale competenties de belangrijke vaardigheid van kritisch negeren moeten omvatten: dat betekent, bewust kiezen wat men negeert en waar men zijn beperkte aandachtscapaciteit investeert.

Kennis over psychologische afhankelijkheid

Digitale media kunnen makkelijk psychologische afhankelijkheid creeren. Social media triggeren het dopamine-beloningssystem op een ongezonde manier door onverwachte dingen te tonen, of door sociale erkenning, of door visuele en auditieve stimulie (mededelingen) en het creeren van verwachtingen. Deze krachtige dopamine-overreactie is ongezond en wordt vaak gevolgd door een gevoel van leegte (geheel anders dan bij activiteiten zoals bewegen).

Bepaalde sociale groepen kunnen moeilijk met de triggers van digitale media omgaan. Dit geldt met name voor eenzame mensen, die in eerste instantie social media als sociaal contact beleven, maar in de echte sociale wereld steeds eenzamer worden.

Op school en thuis moet er ruim aandacht aan deze processen worden besteed om al bij kinderen en jongeren kennis als preventieve steun te bevorderen.

Kritisch negeren van online-manipulatie

Selectief omgaan met beschikbare informatie is in feite de kern van de menselijke cognitie. Dat betekent, dat we onze aandacht op bepaalde delen van de werkelijkheid om ons heen kunnen richten en andere stimuli negeren. Dat gebeurt zowel automatisch alsook bewust.

Automatisch richten we de aandacht op een boek en horen geen lawaai op straat.

Bewust sturen we onze aandacht bij het studeren of bij het mediteren.

We moeten leren om ook online triggers beter te filteren en onze aandacht selectief op voor ons relevante informatie te richten. Aandacht actief sturen in plaats van passief mee te gaan in respons op triggers. Het is essentieel om de informatie-input via zelfsturing te reguleren.

“Mindfulness” is een populair middel tegen moderne overstimulatie en voor mentale gezondheid. Mindful omgaan met online informatie is dan ook een mooi doel.

Sommige platforms maken het mogelijk om berichten te filteren, bijvoorbeeld op personen (trolls) of op bepaalde woorden. Het is dan ook sterk aan te bevelen om hier maximaal gebruik van te maken.

Google breidt ‘prebunking’-programma uit

Google gaat in Duitsland een nieuwe campagne starten om mensen weerbaarder te maken tegen de schadelijke effecten van online desinformatie.

Ook is Google van plan een reeks korte video’s uit te brengen die de manipulatieve technieken belichten die desinformatie structureel gebruikt. De video’s zullen in Duitsland als advertenties verschijnen op platforms als Facebook, YouTube of TikTok. Een soortgelijke campagne in India is ook in de maak.

Dit prebunking leert mensen leren hoe ze valse beweringen kunnen herkennen.

Mediawijsheid en manipulatoren

Filteren van desinformatie of prebunking hoort bij het begrip mediawijsheid. Hierbij gaat het erom mensen, die zich nog niet bewust zijn van de manipulatieve technieken in social media de invloedprocessen en mechanismen spelenderwijs duidelijk te maken. De doelgroep zijn hierbij personen, die min of meer passief en automatisch meedoen aan het destructieve spel in de soziale platforms.

Maar er is een andere groep, een groep die zelf bij de manipulatoren hoort en bewust en doelgericht manipuleert. Deze groep spint juist garen bij manipulatieve beinvloedingsprocessen. Hierbij horen een grote groep aan personen en bedrijven, die direct of indirect geld aan desinformatie verdienen, maar ook degene, die bewust de democratie willen verstoren door chaos te genereren. Deze groep is helaas groeiend. –Onderzoeker Michael Bang Petersen noemt de motieven van deze groep, vaak verspreider van complottheorieen, “Need for Chaos”. Bij mensen die chaos doelgericht inzetten om de democratie te beschadigen helpt geen prebunking. Om met deze groep om te gaan moet mijn zich eerder verdiepen in het onderwerp radicalisering.

Literatuur:

Berry, J. M., & Sobieraj, S. (2013). The outrage industry: Political opinion media and the new incivility. Oxford University Press.

Ceylan, G., Anderson, I. A., & Wood, W. (2023). Sharing of misinformation is habitual, not just lazy or biased. Proceedings of the National Academy of Sciences, 120(4), e2216614120.

Huijstee, M. V., Nieuwenhuizen, W., Sanders, M., Masson, E., & Boheemen, P. V. (2021). Online ontspoord.

Kozyreva, A., Wineburg, S., Lewandowsky, S., & Hertwig, R. (2022). Critical ignoring as a core competence for digital citizens. Current Directions in Psychological Science, 09637214221121570.

Van der Linden, S., & Roozenbeek, J. (2020). Psychological inoculation against fake news. The psychology of fake news: Accepting, sharing, and correcting misinformation, 147-169.

McIntyre, L. C. (2021). How to talk to a science denier : conversations with flat Earthers, climate deniers, and others who defy reason.

Rauch, J. (2021). The constitution of knowledge: A defense of truth. Brookings Institution Press.

Robertson, C. E., Pröllochs, N., Schwarzenegger, K., Pärnamets, P., Van Bavel, J. J., & Feuerriegel, S. (2023). Negativity drives online news consumption. Nature Human Behaviour, 1-11.

Roozenbeek, J., Van Der Linden, S., Goldberg, B., Rathje, S., & Lewandowsky, S. (2022). Psychological inoculation improves resilience against misinformation on social media. Science Advances, 8(34), eabo6254.